La ética de la inteligencia artificial (IA) se ha convertido en un tema de creciente relevancia en la sociedad contemporánea, especialmente a medida que las tecnologías avanzan y se integran en diversos aspectos de la vida cotidiana. La IA, que abarca desde algoritmos de aprendizaje automático hasta sistemas de procesamiento del lenguaje natural, plantea preguntas fundamentales sobre cómo deben ser diseñados y utilizados estos sistemas. La ética en este contexto no solo se refiere a la moralidad de las decisiones que toman las máquinas, sino también a las implicaciones sociales, económicas y políticas que surgen de su implementación.

A medida que la IA se convierte en una herramienta omnipresente en sectores como la salud, la educación y la seguridad, es crucial considerar cómo estas tecnologías pueden afectar a los individuos y a la sociedad en su conjunto. La ética de la IA busca establecer principios que guíen el desarrollo y uso de estas tecnologías, asegurando que se alineen con los valores humanos y promuevan el bienestar social. Este enfoque ético es esencial para abordar las preocupaciones sobre el sesgo algorítmico, la privacidad y la autonomía, entre otros temas críticos.

Resumen

- La ética de la inteligencia artificial es un tema de creciente importancia en el campo de la tecnología.

- Los desarrollos recientes en inteligencia artificial plantean desafíos éticos en términos de privacidad, discriminación y toma de decisiones.

- La implementación de la inteligencia artificial enfrenta desafíos éticos relacionados con la responsabilidad y transparencia en su uso.

- Las regulaciones emergentes en el campo de la inteligencia artificial buscan abordar preocupaciones éticas y garantizar un uso responsable de esta tecnología.

- La ética juega un papel fundamental en el diseño y desarrollo de la inteligencia artificial, con un enfoque en la responsabilidad y la transparencia en su uso.

Desarrollos recientes en la inteligencia artificial y su impacto ético

Desarrollos y preocupaciones éticas

Sin embargo, estos desarrollos también han suscitado preocupaciones éticas sobre su uso y sus consecuencias.

El debate sobre la privacidad y la vigilancia

Por ejemplo, el uso de algoritmos de reconocimiento facial ha generado un intenso debate sobre la privacidad y la vigilancia. En varias ciudades del mundo, estos sistemas se han implementado para mejorar la seguridad pública, pero también han sido criticados por su potencial para perpetuar sesgos raciales y violar derechos civiles. La falta de transparencia en cómo funcionan estos algoritmos y cómo se toman las decisiones ha llevado a llamados para una mayor regulación y supervisión.

La necesidad de un marco ético

Este tipo de dilemas éticos resalta la necesidad de un marco que garantice que los beneficios de la IA no vengan a expensas de los derechos individuales.

Desafíos éticos en la implementación de la inteligencia artificial

La implementación de la inteligencia artificial enfrenta múltiples desafíos éticos que deben ser abordados para garantizar un uso responsable y equitativo. Uno de los principales problemas es el sesgo algorítmico, que puede surgir cuando los datos utilizados para entrenar modelos de IA reflejan prejuicios existentes en la sociedad. Esto puede resultar en decisiones injustas que afectan desproporcionadamente a ciertos grupos, exacerbando desigualdades sociales.

Además, la opacidad en los procesos de toma de decisiones de la IA plantea otro desafío significativo. Muchos sistemas de IA operan como «cajas negras», lo que significa que es difícil entender cómo llegan a ciertas conclusiones. Esta falta de claridad puede generar desconfianza entre los usuarios y dificultar la rendición de cuentas.

Por ejemplo, en el ámbito judicial, el uso de algoritmos para predecir la reincidencia puede influir en sentencias sin que los jueces comprendan completamente cómo se llegó a esa recomendación. La necesidad de desarrollar modelos más explicativos y transparentes es crucial para abordar estos desafíos éticos.

Regulaciones emergentes en el campo de la inteligencia artificial

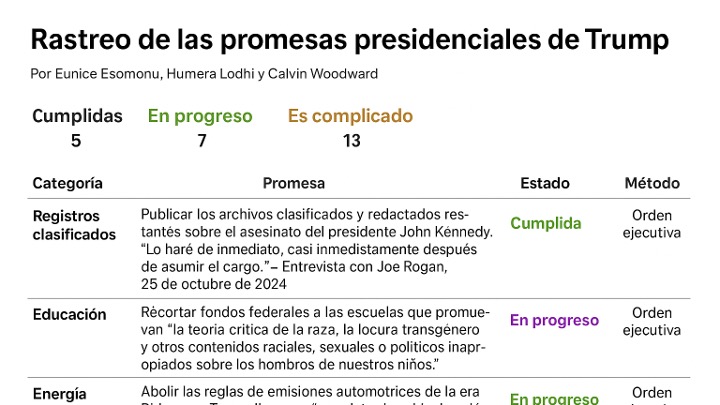

| País | Regulación | Fecha de implementación |

|---|---|---|

| Unión Europea | Reglamento General de Protección de Datos (GDPR) | 25 de mayo de 2018 |

| Estados Unidos | Leyes estatales sobre el uso de reconocimiento facial | Varía según el estado |

| China | Regulaciones sobre el uso de inteligencia artificial en la industria automotriz | En proceso de implementación |

| Canadá | Marco de ética en inteligencia artificial | En proceso de implementación |

A medida que las preocupaciones éticas en torno a la inteligencia artificial han crecido, también lo ha hecho el interés por establecer regulaciones que guíen su desarrollo y uso. En Europa, por ejemplo, se ha propuesto un marco regulatorio integral conocido como el Reglamento General sobre la Inteligencia Artificial (AI Act), que busca establecer normas claras para el uso seguro y ético de la IEste reglamento clasifica las aplicaciones de IA en diferentes niveles de riesgo y establece requisitos específicos para cada categoría. En Estados Unidos, aunque no existe una regulación federal específica para la IA, varias iniciativas estatales y locales han comenzado a abordar cuestiones éticas relacionadas con su uso.

Por ejemplo, algunas ciudades han prohibido el uso de tecnología de reconocimiento facial por parte de las fuerzas del orden debido a preocupaciones sobre su impacto en comunidades marginadas. Estas regulaciones emergentes reflejan un reconocimiento creciente de la necesidad de equilibrar la innovación tecnológica con consideraciones éticas y sociales.

El papel de la ética en el diseño y desarrollo de la inteligencia artificial

La ética debe ser un componente integral en el diseño y desarrollo de sistemas de inteligencia artificial. Esto implica no solo considerar las implicaciones éticas durante las fases iniciales del desarrollo, sino también implementar prácticas que fomenten una cultura ética dentro de las organizaciones tecnológicas. La inclusión de equipos diversos en el proceso de desarrollo puede ayudar a identificar y mitigar sesgos potenciales desde el principio.

Además, es fundamental establecer principios éticos claros que guíen el trabajo en IOrganizaciones como el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE) han desarrollado marcos éticos que abordan cuestiones como la justicia, la privacidad y la responsabilidad. Estos principios pueden servir como guía para los desarrolladores e ingenieros al crear sistemas que no solo sean eficientes, sino también justos y responsables.

Responsabilidad y transparencia en el uso de la inteligencia artificial

La responsabilidad crítica

La responsabilidad es un aspecto crítico en el uso de la inteligencia artificial, especialmente cuando se trata de decisiones que afectan vidas humanas. Las organizaciones deben ser responsables no solo por los resultados directos de sus sistemas de IA, sino también por las consecuencias indirectas que puedan surgir. Esto incluye garantizar que haya mecanismos adecuados para abordar errores o sesgos en los sistemas.

La transparencia es fundamental

La transparencia es igualmente importante; los usuarios deben tener acceso a información clara sobre cómo funcionan los sistemas de IA y cómo se toman las decisiones. Esto no solo fomenta la confianza entre los usuarios, sino que también permite una mayor rendición de cuentas. Por ejemplo, algunas empresas están comenzando a publicar auditorías sobre sus algoritmos para demostrar su compromiso con prácticas éticas.

Desafíos pendientes

Sin embargo, aún queda mucho por hacer para establecer estándares claros sobre lo que constituye una transparencia adecuada en este campo.

Ética y privacidad en la era de la inteligencia artificial

La intersección entre ética y privacidad es uno de los temas más críticos en el contexto de la inteligencia artificial. A medida que las tecnologías recopilan y analizan grandes cantidades de datos personales, surge una preocupación legítima sobre cómo se utilizan esos datos y quién tiene acceso a ellos. La recopilación masiva de datos puede llevar a violaciones graves de la privacidad si no se maneja adecuadamente.

Las leyes existentes sobre protección de datos, como el Reglamento General de Protección de Datos (GDPR) en Europa, buscan abordar algunas de estas preocupaciones al establecer normas sobre cómo se deben manejar los datos personales. Sin embargo, con el avance continuo de la IA, es probable que se necesiten regulaciones adicionales para abordar específicamente los desafíos únicos que presenta esta tecnología. La ética debe guiar no solo cómo se recopilan y utilizan los datos, sino también cómo se informa a los usuarios sobre sus derechos y opciones.

El futuro de la ética de la inteligencia artificial: tendencias y proyecciones para 2025

Mirando hacia el futuro, es probable que veamos un aumento en el enfoque ético dentro del desarrollo e implementación de tecnologías de inteligencia artificial. A medida que más organizaciones reconozcan la importancia de integrar principios éticos en sus prácticas, es posible que surjan nuevas iniciativas colaborativas entre empresas, gobiernos y organizaciones no gubernamentales para abordar estos desafíos. Además, es probable que veamos un crecimiento en las certificaciones éticas para productos y servicios basados en IEstas certificaciones podrían ayudar a los consumidores a tomar decisiones informadas sobre qué tecnologías utilizar, basándose en su alineación con valores éticos específicos.

A medida que avanzamos hacia 2025, será esencial seguir monitoreando estas tendencias y adaptando nuestras prácticas para garantizar que la inteligencia artificial beneficie a toda la sociedad sin comprometer principios éticos fundamentales.